Содержание

Дифференциал автомобиля. Разновидности и особенности функционирования

- Полная принудительная блокировка

- Дисковая (фрикционная) блокировка

- Вискомуфта

- Торсен

- QUAIFE

Дифференциалом называется механизм, передающий вращающий момент от одного источника двум потребителям. Его ключевой особенностью является способность перераспределять мощность и обеспечивать разные угловые скорости вращения потребителей. Применительно к дорожному транспортному средству это означает, что посредством дифференциала колеса могут получать разную мощность и вращаться с разной скоростью.

Дифференциал является важным элементом автомобильной трансмиссии. Попробуем разобраться, почему так.

Почему нельзя обойтись без дифференциала

Строго говоря, без дифференциала можно обойтись. Но только до тех пор, пока автомобиль движется по безупречной трассе, никуда не сворачивая, а шины у него одинаковые и равномерно накачанные. Иными словами, пока все колеса проезжают одинаковый путь и вращаются с одинаковой скоростью.

Но когда машина входит в поворот, колесам приходится преодолевать разное расстояние. Очевидно, что внешняя дуга поворота длиннее внутренней, поэтому колесам, движущимся по ней, приходится крутиться быстрее, чем колесам, проезжающим по внутренней дуге. Когда ось не является ведущей, а колеса не зависят одно от другого, то никакой проблемы нет.

Иное дело — ведущий мост. Для осуществления нормального управления вращение передается на оба колеса. При их жесткой связи они имели бы одинаковую угловую скорость и в повороте стремились бы проехать одинаковое расстояние. Поворот был бы затруднен и приводил бы к пробуксовке, повышенному стиранию шин и излишней нагрузке на трансмиссию. Часть мощности двигателя уходила бы на пробуксовку, а значит и топливо расходовалось бы понапрасну. Нечто подобное, хотя и не столь очевидно, происходит и в других ситуациях — при езде по неровной дороге, неравномерной нагрузке на колеса, неодинаковом давлении в шинах, различной степени износа покрышек.

Часть мощности двигателя уходила бы на пробуксовку, а значит и топливо расходовалось бы понапрасну. Нечто подобное, хотя и не столь очевидно, происходит и в других ситуациях — при езде по неровной дороге, неравномерной нагрузке на колеса, неодинаковом давлении в шинах, различной степени износа покрышек.

Вот тут и приходит на помощь дифференциал. Он передает вращение на обе полуоси, но соотношение угловых скоростей вращения колес может быть произвольным и меняться оперативно в зависимости от конкретной ситуации без вмешательства водителя.

Виды дифференциалов

Дифференциалы бывают симметричными и несимметричными. Симметричные передают на оба ведомых вала одинаковый вращающий момент, при использовании несимметричных устройств передаваемые моменты различны.

Функционально дифференциалы могут применяться в качестве межколесных и межосевых. Межколесный передает вращающий момент колесам одной оси. В переднеприводном авто он размещен в КПП, в заднеприводном — в картере заднего моста.

В полноприводной машине механизмы находятся в картерах обоих мостов. Если полный привод является постоянным, в раздаточной коробке монтируется еще и межосевой дифференциал. Он передает вращение от коробки передач на оба ведущих моста.

Межколесный дифференциал всегда симметричный, а вот межосевой обычно бывает несимметричным, типовое процентное соотношение моментов между передней и задней осью — 40/60, хотя может быть и иным.

Возможность и способ блокировки определяет еще одну классификацию дифференциалов:

Блокировка может быть как полной, так и частичной.

Как функционирует дифференциал и зачем его блокировать

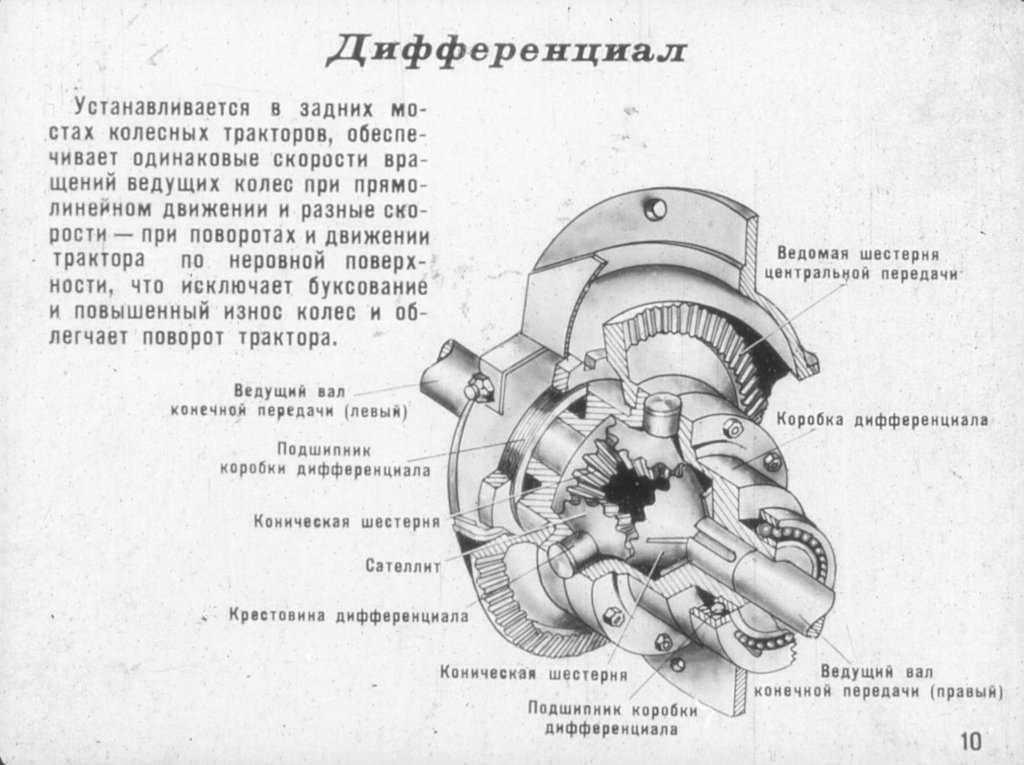

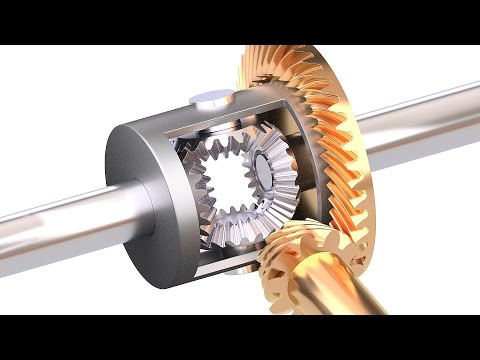

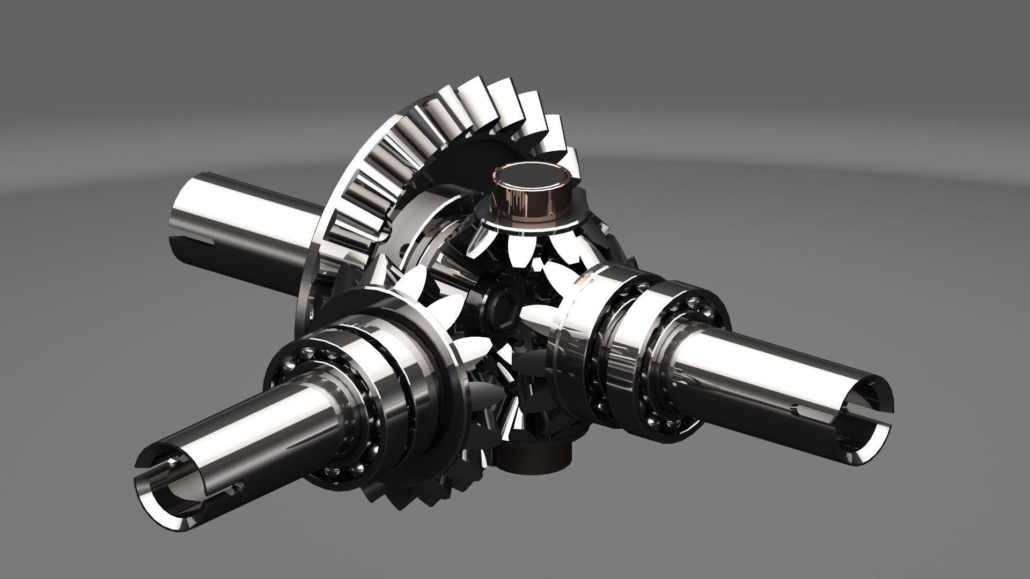

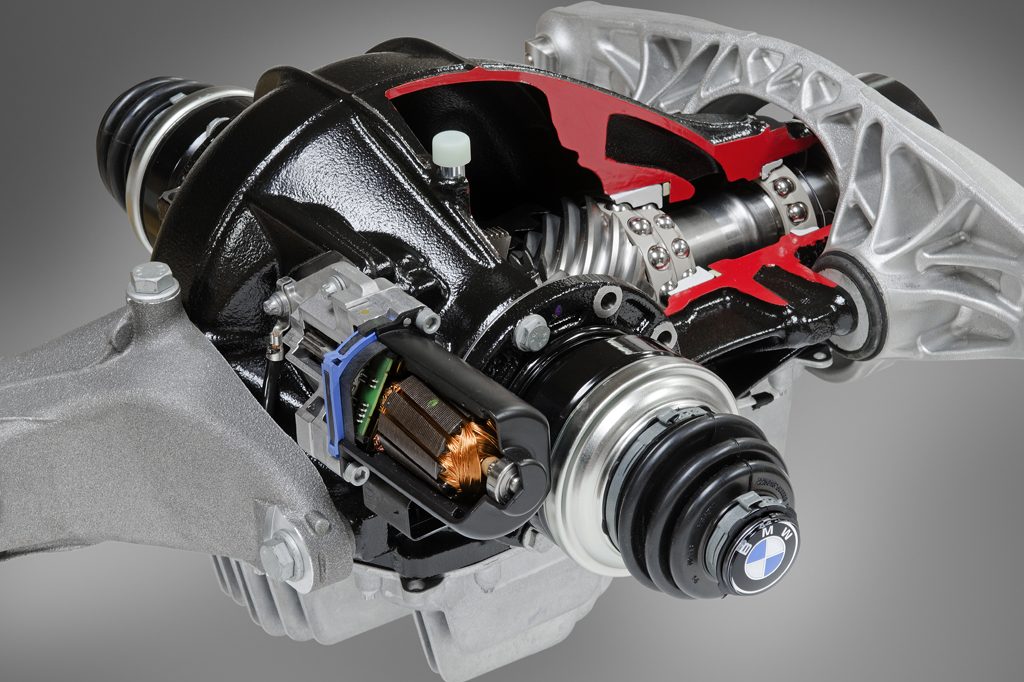

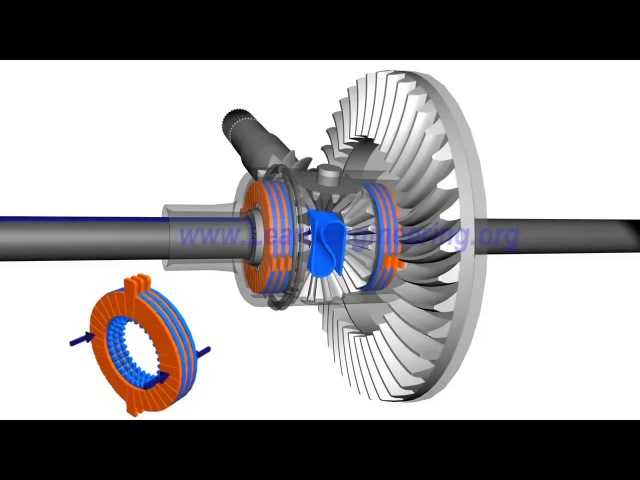

По сути дифференциал — это механизм планетарного типа. В самом простом симметричном межколесном дифференциале четыре конические шестерни — две полуосевые (1) плюс два сателлита (4). Схема работает и с одним сателлитом, но второй добавлен, чтобы сделать устройство более мощным. В грузовиках и внедорожниках ставят две пары сателлитов.

В грузовиках и внедорожниках ставят две пары сателлитов.

Чашка (корпус) (5) выполняет роль водила для сателлитов. В ней жестко закреплена большая ведомая шестерня (2). Она получает вращающий момент от КПП посредством ведущей шестерни главной передачи (3).

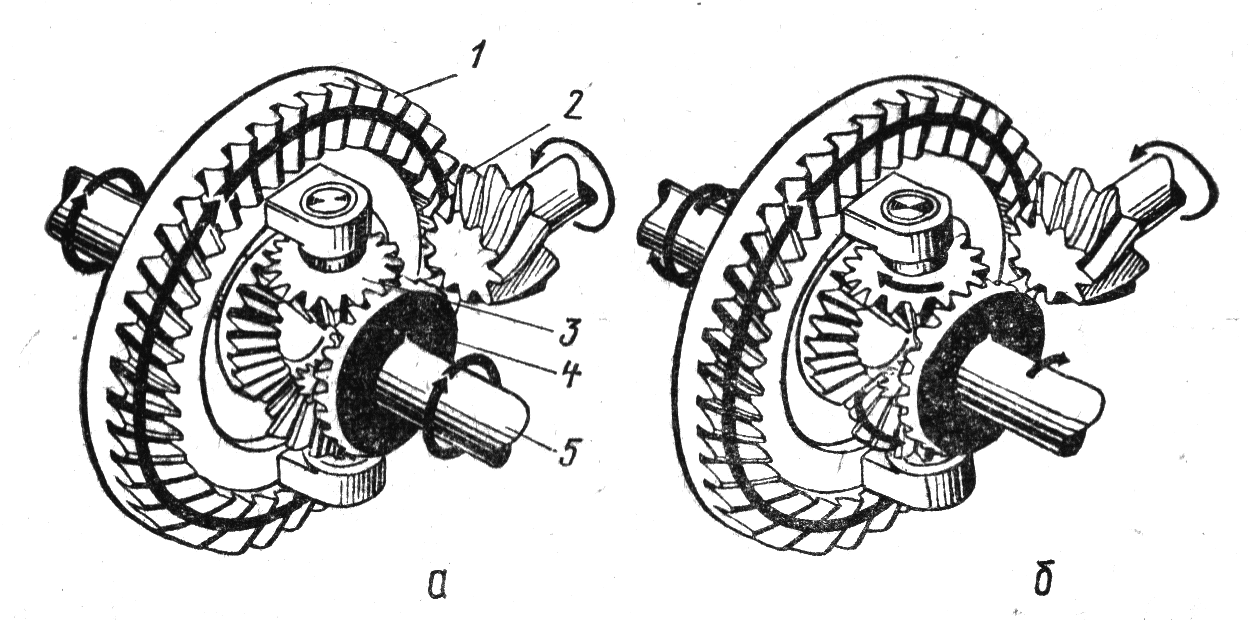

На прямой дороге колеса, а значит, и их полуоси

крутятся с одинаковой угловой скоростью. Сателлиты совершают обороты вокруг колесных полуосей, но вокруг собственных осей не вращаются. Таким образом они вращают полуосевые шестерни, придавая им одинаковую угловую скорость.

В повороте у колеса, идущего по внутренней (меньшей) дуге, сопротивление качению больше и потому оно замедляется. Поскольку соответствующая полуосевая шестерня также начинает вращаться медленнее, она заставляет крутиться сателлиты. Их вращение вокруг собственной оси приводит к увеличению оборотов шестерни на полуоси наружного колеса.

Подобная ситуация может возникнуть и в тех случаях, когда покрышки имеют недостаточное сцепление с дорогой. К примеру, колесо попадает на лед и начинает проскальзывать. Обычный свободный дифференциал станет передавать вращение туда, где сопротивление меньше. В результате проскальзывающее колесо будет вращаться еще быстрее, а противоположное практически остановится. Машина в итоге не сможет продолжить движение. Причем картина принципиально не изменится и в случае полного привода, поскольку межосевой дифференциал также передаст всю мощность туда, где встретит меньшее сопротивление, то есть на мост с проскальзывающим колесом. В итоге даже полноприводный автомобиль может застрять, если забуксует всего одно колесо.

К примеру, колесо попадает на лед и начинает проскальзывать. Обычный свободный дифференциал станет передавать вращение туда, где сопротивление меньше. В результате проскальзывающее колесо будет вращаться еще быстрее, а противоположное практически остановится. Машина в итоге не сможет продолжить движение. Причем картина принципиально не изменится и в случае полного привода, поскольку межосевой дифференциал также передаст всю мощность туда, где встретит меньшее сопротивление, то есть на мост с проскальзывающим колесом. В итоге даже полноприводный автомобиль может застрять, если забуксует всего одно колесо.

Данное явление серьезно ухудшает проходимость любого автомобиля и совершенно неприемлемо для внедорожников. Исправить ситуацию можно блокированием дифференциала.

Типы блокировок

Полная принудительная блокировка

Добиться полной ручной блокировки можно, заклинив сателлиты так, чтобы лишить их возможности крутиться вокруг собственной оси. Другой способ — ввести чашку дифференциала в жесткое зацепление с полуосью. Оба колеса станут крутиться с равной угловой скоростью.

Другой способ — ввести чашку дифференциала в жесткое зацепление с полуосью. Оба колеса станут крутиться с равной угловой скоростью.

Для включения данного режима нужно всего лишь нажать кнопку на приборной панели. В приводном устройстве может быть задействована механика, гидравлика, пневматика либо электромотор. Такая схема годится и для межколесных и для межосевых дифференциалов. Включать ее можно, когда машина стоит на месте, а пользоваться следует лишь на малой скорости при езде по пересеченной местности. Выехав на нормальную дорогу, блокировку обязательно нужно отключить, иначе управляемость заметно ухудшится. Злоупотребление этим режимом может стать причиной поломки полуоси или сопряженных с ней деталей.

Больший интерес представляют самоблокирующиеся дифференциалы. Они не требуют вмешательства водителя и срабатывают автоматически, когда возникает надобность. Поскольку блокировка в таких устройствах неполная, то вероятность повреждения полуосей невелика.

Дисковая (фрикционная) блокировка

Это наиболее простой вариант самоблокирующегося дифференциала. Механизм дополнен набором фрикционных дисков. Они плотно прилегают друг к другу и через один жестко закреплены на одной из полуосей и в чашке.

Вся конструкция крутится как единое целое, пока скорость вращения колес не становится разной. Тогда между дисками появляется трение, ограничивающее рост разности скоростей.

Вискомуфта

Подобный принцип функционирования имеет и вискомуфта (вязкостная муфта). Только здесь диски с нанесенной на них перфорацией размещены в герметичном боксе, все свободное пространство которого заполнено силиконовой жидкостью. Ее отличительная особенность — изменение вязкости при перемешивании. Когда диски крутятся с разной скоростью, жидкость перемешивается, и чем интенсивнее перемешивание, тем более вязкой становится жидкость, доходя почти до твердого состояния. Когда скорость вращения выравнивается, вязкость жидкости быстро падает, и дифференциал разблокируется.

Когда скорость вращения выравнивается, вязкость жидкости быстро падает, и дифференциал разблокируется.

Вискомуфта имеет довольно большие габариты, потому используется чаще как дополнение к межосевому дифференциалу, а иногда и вместо него, выполняя в этом случае роль псевдодифференциала.

У вискомуфты есть ряд недостатков, которые существенно ограничивают ее применение. Это инерционность, значительный нагрев и плохая совместимость с ABS.

Торсен

Название происходит от Torque Sensing, то есть «воспринимающий вращающий момент». Считается одним из наиболее эффективных самоблокирующихся дифференциалов. В механизме используется червячная передача. В конструкции также есть фрикционные элементы, дополнительно передающие вращающий момент при возникновении пробуксовки.

Имеется три типа данного механизма. При нормальном сцеплении с дорогой разновидности T-1 и T-2 функционируют как дифференциалы симметричного типа.

Когда одно из колес теряет сцепление, Т-1 способен перераспределить крутящий момент в соотношении от 2,5 к 1 до 6 к 1 и даже больше. То есть колесо, имеющее лучшее сцепление с дорогой, будет получать момент больший, чем у проскальзывающего колеса, в указанной пропорции. У разновидности Т-2 этот показатель ниже — от 1,2 к 1 до 3 к 1, зато меньше люфт, вибрации и шум.

Torsen Т-3 изначально разрабатывался как несимметричный дифференциал с показателем блокирования 20…30 %.

QUAIFE

Дифференциал Квайф назван по фамилии английского инженера, разработавшего данное устройство. По конструкции относится к червячному типу, как и Торсен. Отличается от него количеством сателлитов и их размещением. Quaife весьма популярен среди энтузиастов автомобильного тюнинга.

принцип работы блокировки механизма трансмиссии

Привод на одно колесо в автомобилях не применяется, минимум на два, расположенные на одной оси. Таким образом, возникает необходимость в механизме, распределяющем крутящий момент между ними. Та же задача появляется при попытке организовать полный привод, то есть связь между осями.

Таким образом, возникает необходимость в механизме, распределяющем крутящий момент между ними. Та же задача появляется при попытке организовать полный привод, то есть связь между осями.

Содержание статьи:

- 1 Зачем в машине нужен дифференциал

- 1.1 Где находится

- 1.2 Из чего состоит

- 2 Принцип работы

- 2.1 При прямолинейном движении

- 2.2 При повороте

- 2.3 При пробуксовке

- 3 Виды дифференциалов

- 3.1 Место установки

- 3.2 Вид зубчатой передачи

- 3.3 По принципу блокировки

- 4 Неисправности

- 5 Обслуживание

Зачем в машине нужен дифференциал

Назначение дифференциала – передать вращение на оба колеса или обе оси, при этом позволить им вращаться с разной скоростью.

Если между колёсами обеспечить жёсткую связь, то в поворотах возникнут проблемы. Каждое колесо движется по своей дуге окружности с разными радиусами. Соответственно, путь они проходят различный, и скорость вращения будет отличаться.

При жёсткой посадке на единую ось резина начнёт пробуксовывать, машина крайне неохотно входить в повороты, а все механизмы трансмиссии будут испытывать запредельные перегрузки.

Это интересно: Карбюратор Солекс 21083 устройство и регулировка

Дифференциал развязывает ведущие колёса, позволяя им свободно менять скорость, при этом сохраняет передачу на них крутящего момента, разделив его в определяемом конструкцией соотношении.

Где находится

Межколёсные дифференциалы располагаются в одном картере с редуктором ведущего моста, а межосевые обычно внутри раздаточной коробки.

Смазываются они из единой с редуктором масляной ванны, иногда довольствуясь тем же маслом, что и гипоидная пара шестерён, но часто требуя дополнительных свойств от присадок, если конструкция подразумевает повышенное трение.

Из чего состоит

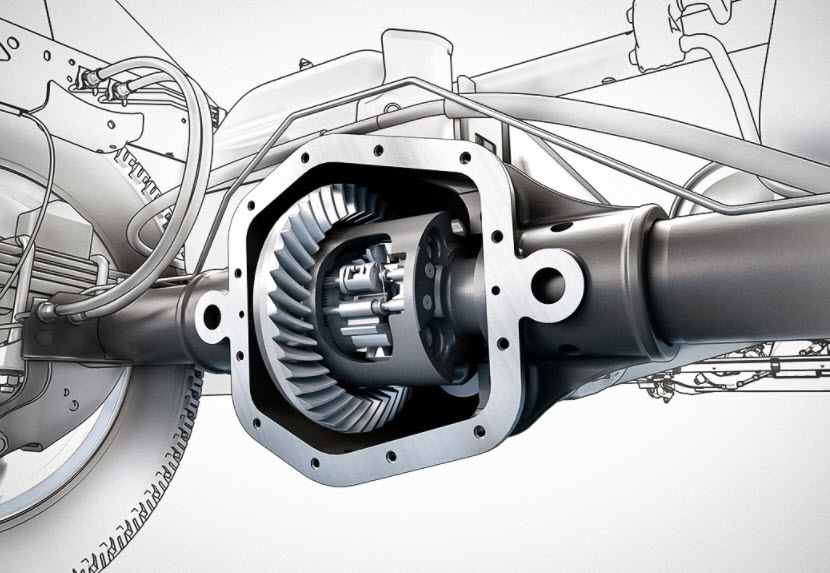

В состав самых распространённых дифференциалов входят:

- корпус (коробка) дифференциала, к которой прикладывается входящий момент через ведомую шестерню главной пары;

- шестерни полуосей, надеты на шлицы выходных валов, через них вращение передаётся на колёса;

- сателлиты, это небольшие шестерни, вращающиеся на осях, связанных с коробкой и входящие в зацепление с полуосевыми шестернями.

В коробке может быть два и более сателлитов, их количество зависит от величины нагрузки, передаваемой через редуктор. В самых распространённых случаях конических сателлитов легковых автомобилей их обычно два, для тяжёлых машин повышенной проходимости (джипов) количество возрастает до четырёх.

Принцип работы

Крутящий момент от двигателя через коробку передач передаётся на корпус дифференциала. У заднеприводных автомобилей посредством карданного вала, при переднем приводе дифференциал обычно устанавливается внутри КПП, образующей в таком случае моноблок трансмиссии, из которого наружу выходят уже шарнирные полуоси к колёсным ступицам.

Далее характер работы зависит от траектории движения и наличия достаточных сцепных свойств дорожного покрытия.

При прямолинейном движении

Когда автомобиль движется прямолинейно по гладкой поверхности с твёрдым сухим покрытием, обе полуоси вращаются с одинаковой угловой скоростью. Полуосевые шестерни находятся в покое одна относительно другой, весь дифференциал сильно похож на монолитную конструкцию.

Сателлиты, будучи связанными через свои зубья с обеими полуосевыми шестернями, относительно своих осей не вращаются. Момент распределяется поровну между осями, если дифференциал симметричный и свободный, то есть лишён блокировок. Впрочем, с блокировками в таком идеальном случае будет то же самое.

При повороте

В повороте, а это обычный режим работы дифференциала, поскольку идеальных прямых в природе не существует, одно из колёс всегда будет вращаться быстрее. Сателлиты придут в движение относительно своих осей, но связь между полуосевыми шестернями и корпусом не утратят. То есть момент продолжит передаваться от корпуса к колёсам, причём всё в том же соотношении 50/50.

Это очень любопытно рассмотреть с точки зрения мощности. Момент одинаков, а скорость у внешнего от поворота колеса больше, то есть и мощность на него передаётся пропорционально большая.

И это неудивительно, так как чем больше скорость, тем выше потери, которые компенсируются добавкой мощности. При этом ни малейших помех вращению колёс с разной скоростью создаваться не будет, в отличие от жёсткой связи.

При этом ни малейших помех вращению колёс с разной скоростью создаваться не будет, в отличие от жёсткой связи.

При пробуксовке

Гораздо менее приятно дела обстоят в том случае, когда одно из колёс попало на относительно скользкий участок дороги и сорвалось в пробуксовку при разгоне. Сцепления с дорогой нет, а значит момент сопротивления покрытия резко падает. Но этот момент всегда равен тяговому, это закон физики. Значит и тяговый момент упадёт.

Свободный симметричный дифференциал делит тягу пополам между колёсами. Всегда 50/50. То есть при падении момента на одном до нуля, на втором он обнулится автоматически. Автомобиль начнёт терять скорость, а если речь идёт о трогании с места на льду или жидкой грязи, то он просто там и останется, не сумев выехать из засады.

Это надо знать: Что означает маркировка фар автомобиля

В этом главный недостаток свободного дифференциала. Он может передать усилие только то, которое способно переварить колесо, находящееся в худших условиях. Даже если второе будет на сухом чистом асфальте, автомобиль никуда не поедет. Вся энергия уйдет на быстрое и бесполезное вращение буксующего колеса.

Даже если второе будет на сухом чистом асфальте, автомобиль никуда не поедет. Вся энергия уйдет на быстрое и бесполезное вращение буксующего колеса.

Виды дифференциалов

Конкретных реализаций дифференциалов много, если не говорить только о самом распространённом – коническом свободном. И классифицировать их можно по разным признакам.

Место установки

Для развязки колёс одной ведущей оси используется межколёсный дифференциал в редукторе ведущего моста. Если этот редуктор установлен в коробке передач переднеприводной машины – значит там и смонтирован дифференциал.

Некоторые машины оснащены постоянным полным приводом. Это означает, что он включён всегда. Но при этом оси могут иметь разную скорость, например, в том же повороте. И тогда в элемент трансмиссии, называемый раздаточной коробкой, внедряется межосевой дифференциал, работающий так же, как было рассмотрено в случае межколёсного.

Вид зубчатой передачи

По типу применяемых зацеплений дифференциалы подразделяются на:

- самый распространённый – конический, по форме полуосевых шестерён и сателлитов;

- цилиндрический, применяется значительно реже, но иногда по компоновочным и функциональным соображениям незаменим, напоминает планетарную передачу;

- червячный, бывает построен разными способами, чаще всего этот тип зацепления используется в самоблокирующихся дифференциалах, червячные пары могут создавать значительное внутреннее трение.

От размеров и организации зубчатых пар зависит также и симметрия дифференциала. Иногда важно отправлять на одну ось больший момент, чем на вторую. Например, в некоторых версиях 4-matic от Mercedes 65% момента идёт на заднюю ось, 35 – на переднюю.

По принципу блокировки

Блокируемые дифференциалы лишены упомянутого выше главного недостатка по части проходимости и динамичного разгона при недостаточном сцеплении с дорогой.

Достигается это разными способами:

- Дисковые блокировки и их менее эффективные разновидности LSD работают по принципу поджатия пакета фрикционных дисков по мере увеличения разности в скоростях между колёсами оси, в результате часть момента всё же поступает на ту сторону, где есть зацеп;

- Червячные работают примерно так же, но несколько мягче, за счёт дополнительного проворота сателлитов червячного типа перед их упором торцами в корпус с последующей блокировкой относительного смещения полуосей, это самые распространённые типы самоблоков, различаются ориентацией сателлитов относительно оси;

- Электронной блокировкой принято называть её имитацию, когда вывешенное колесо зажимается тормозными колодками и момент перебрасывается на загруженное, чем эта схема работает эффективней, тем больше потери, перегрузки и износ тормозов, тем не менее она часто спасает легковые машины и кроссоверы в трудной ситуации;

- Вискомуфты могут выполнять роль как дифференциалов, так и их блокировок, в первом случае они включаются последовательно в линию передачи момента и могут её прерывать, а во втором – блокируют входной и выходной валы, препятствуя работе свободного дифференциала.

Самой эффективной блокировкой будет жёсткая механическая с электрическим или пневмоприводом. Именно так и сделано на лучших внедорожниках, там блокируются все три дифференциала, межосевой и два межколёсных.

Неисправности

Свободный дифференциал достаточно надёжен и сам не сломается. Но его очень часто ломает водитель своими паническими действиями при буксовании автомобиля.

Дело в том, что шестерёнки дифференциала работают на подшипниках скольжения, причём самых простейших. Они не рассчитаны на долгое и тяжёлое вращение под нагрузкой, когда крутится только одно колесо.

Антифрикционные шайбы перегреваются, зубья изнашиваются, появляются люфты и стуки, а при резкой остановке колеса, внезапно попавшего на асфальт после раскрутки, ломаются оси сателлитов и шлицевые соединения.

Ремонт чаще всего заключается в замене коробки дифференциала в сборе. Иногда можно поставить ремкомплект из шестерён и пальца с новыми регулировочными шайбами. Совсем редко обходятся только регулировкой подбором шайб.

Обслуживание

ТО исправного дифференциала сводится к замене масла в редукторе или раздатке. Никаких регулировочных или иных сервисных операций не предусмотрено, только ремонт при износе и поломках. На самоблоках иногда потребуется восстановить величину предварительного натяга подбором пакета пружинных шайб.

Обычно все дифференциалы повышенного трения требуют применения специального масла типа LSD (Limited Slip), но сейчас лучшие универсальные масла уже обладают подобными свойствами, о чём указано на этикетке.

В любом случае, лучше руководствоваться инструкцией изготовителя конкретного изделия.

Что такое дифференциальная подача? — WeAllSew

Вы когда-нибудь шили трикотажем и заканчивали шов только для того, чтобы заметить, что край теперь длиннее, чем в начале? И, возможно, у него есть забавная волнистость, которой раньше не было. . . Ну, вы не одиноки. Большинство современных оверлоков имеют функцию, называемую дифференциальной подачей, и эта простая настройка поможет вам добиться идеальной отделки шва. В дополнение к исправлению растянутого шва на трикотажных тканях, эту функциональную настройку можно также использовать для создания сборок или фестончатой отделки края салата. Как только вы поймете основы того, как он работает, вам будет легко найти способы использовать его при работе над вашим следующим проектом.

. . Ну, вы не одиноки. Большинство современных оверлоков имеют функцию, называемую дифференциальной подачей, и эта простая настройка поможет вам добиться идеальной отделки шва. В дополнение к исправлению растянутого шва на трикотажных тканях, эту функциональную настройку можно также использовать для создания сборок или фестончатой отделки края салата. Как только вы поймете основы того, как он работает, вам будет легко найти способы использовать его при работе над вашим следующим проектом.

Характеристики машины: BERNINA L 460

Обзор: Что такое дифференциальная подача?

Этот термин часто путают с Двойной подачей ткани (функция некоторых швейных машин BERNINA, позволяющая использовать верхний транспортер для равномерного продвижения ткани через машину) или неправильно используют для обозначения давления прижимной лапки (величины давления, с которым прижимная лапка встречается с зубчатой рейкой), но это не так. Когда я впервые узнал об оверлоках, я обнаружил, что дифференциальная подача сбивает с толку, и я не знал, что именно она делала, когда меняла ее. Конечно, опыт — лучший учитель, и после нескольких возможностей использовать его в некоторых проектах концепция стала для меня более ясной.

Когда я впервые узнал об оверлоках, я обнаружил, что дифференциальная подача сбивает с толку, и я не знал, что именно она делала, когда меняла ее. Конечно, опыт — лучший учитель, и после нескольких возможностей использовать его в некоторых проектах концепция стала для меня более ясной.

Как и в швейной машине, оверлок также использует систему зубчатой рейки для перемещения ткани через машину. Однако, в отличие от швейной машины, у оверлока ДВА комплекта зубчатых рейок! И это, друзья мои, ключ к пониманию дифференциальной подачи.

Когда вы регулируете ручку дифференциальной подачи на своей машине, вы фактически регулируете скорость, с которой движется передняя гребенка. Зубчатая рейка обратной подачи всегда будет вращаться одинаково. В инструкции к оверлоку есть схематический рисунок, иллюстрирующий эту концепцию.

Схема машинного руководства

Основная идея заключается в том, что когда дифференциальная подача установлена на 2, передняя зубчатая рейка будет вращаться примерно в два раза дальше, чем задняя, таким образом перемещая гораздо больше ткани, чем задняя. собака. Это то, что устраняет растянутую волну, которая создается при шитье большинства трикотажных тканей.

собака. Это то, что устраняет растянутую волну, которая создается при шитье большинства трикотажных тканей.

Напротив, когда ручка дифференциальной подачи установлена на 0,7, передняя гребенка делает меньший оборот, чем задняя гребенка. Задний транспортер ткани теперь тянет больше ткани, чем передний транспортер, и, следовательно, растягивает ткань во время шитья.

Конечно, когда ручка установлена на 1, обе зубчатые рейки движутся с одинаковой скоростью. Еще одна вещь, которую следует отметить в отношении дифференциальной подачи, заключается в том, что она является переменной и регулируемой во время шитья. Это означает, что вы не ограничены числами/соотношениями, отображаемыми в качестве настроек, и, что наиболее важно, вы можете настроить их во время шитья вашего проекта — привет косые края и втачные рукава!

Итак, как узнать, где его установить и почему? Давайте рассмотрим некоторые варианты в примерах ниже.

Стежок 1. Настройка дифференциальной подачи на 1

Выбор ткани определяет, где установить настройку дифференциальной подачи, больше, чем какие-либо жесткие правила. Как правило, для большинства тканых материалов получается хороший плоский шов вдоль несмещенного края среза при настройке 1, как в этом образце, показывающем два слоя желтой джинсовой ткани.

Как правило, для большинства тканых материалов получается хороший плоский шов вдоль несмещенного края среза при настройке 1, как в этом образце, показывающем два слоя желтой джинсовой ткани.

Стежок 2. Дифференциальная подача ткани, установленная на 1,5

Часто, хотя и не всегда, трикотажные ткани растягиваются во время шитья и создают волнистый край, когда дифференциальная подача установлена на 1. Чтобы исправить этой волнистости, отрегулируйте настройку дифференциальной подачи до отметки 1,5, пока шов не станет плоским и ровным. Посмотрите, как эта регулировка может изменить базовый трикотаж джерси, показанный здесь.

Стежок 3. Настройка дифференциальной подачи 2

Мой любимый способ использования настройки дифференциальной подачи 2 — это создание оборок. На самом деле, я научился легко запоминать эту конкретную настройку: собрать «2» вместе . Я могу или не могу говорить это себе каждый раз, когда использую эту функцию. Поскольку передняя гребенка проталкивает больше ткани, чем задняя, почти в два раза быстрее, она легко собирает ткани в красивый рюш. Объедините эту технику с закругленным краем, и вы сможете создавать оборки для подушек, сумок и милой детской одежды.

Поскольку передняя гребенка проталкивает больше ткани, чем задняя, почти в два раза быстрее, она легко собирает ткани в красивый рюш. Объедините эту технику с закругленным краем, и вы сможете создавать оборки для подушек, сумок и милой детской одежды.

Строчка 4. Дифференциальная подача ткани Настройка на 0,7

Роликовая подгибка — прекрасный способ отделки края многих тканей. Добавив регулировку дифференциальной подачи на 0,7, вы можете создать зубчатый край салата. Этот параметр также можно использовать для устранения любых нежелательных складок, которые могут возникнуть на ваших тканях.

Совет: Использование эластичного трикотажа из спандекса действительно усилит эффект края салата.

Я надеюсь, что это помогло определить использование дифференциальной подачи и объяснить, как вы можете использовать ее в будущих проектах. Оверлок — это мощный инструмент, который обеспечивает профессиональную отделку каждого проекта. Удачного сержинга!

Удачного сержинга!

Машинное обучение с дифференциальной конфиденциальностью в TensorFlow

Николя Паперно

Дифференциальная конфиденциальность — это основа для измерения гарантий конфиденциальности

обеспечивается алгоритмом. Через призму дифференцированной конфиденциальности мы можем

разрабатывать алгоритмы машинного обучения, которые ответственно обучают модели на частных

данные. Обучение с дифференциальной конфиденциальностью обеспечивает доказуемые гарантии

конфиденциальность, снижая риск раскрытия конфиденциальных данных обучения на машине

обучение. Интуитивно понятно, что модель, обученная дифференциальной конфиденциальности, не должна

зависит от любого отдельного обучающего примера или небольшого набора обучающих примеров в его наборе данных.

Вы можете вспомнить нашу предыдущую запись в блоге о PATE,

подход, который обеспечивает частное обучение путем тщательного

координация деятельности нескольких разных ML

модели [Papernot et al. ].

].

В этом посте вы узнаете, как обучать дифференциально-частную модель с помощью

другой подход, который опирается на дифференциально

Частный стохастический градиентный спуск (DP-SGD) [Абади и др.].

DP-SGD и PATE — это два разных способа достижения одной и той же цели сохранения конфиденциальности.

машинное обучение. DP-SGD делает меньше предположений о задаче ML, чем PATE,

но это происходит за счет внесения изменений в алгоритм обучения.

Действительно, DP-SGD

модификация алгоритма стохастического градиентного спуска,

который является основой для многих оптимизаторов, популярных в машинном обучении.

Модели, обученные с помощью DP-SGD, имеют доказуемые гарантии конфиденциальности, выраженные в терминах

дифференциальной конфиденциальности (мы объясним, что это значит, в конце этого

почта). Мы будем использовать библиотеку TensorFlow Privacy,

который обеспечивает реализацию DP-SGD, чтобы проиллюстрировать наше представление DP-SGD

и предоставить практическое руководство.

Единственным предварительным условием для прохождения этого урока является умение тренировать

простая нейронная сеть с TensorFlow. Если вы не знакомы с

Если вы не знакомы с

сверточные нейронные сети или как их тренировать, рекомендуем прочитать

этот урок первым

чтобы начать работу с TensorFlow и машинным обучением.

По завершении обучения, представленного в этом посте,

вы сможете обернуть существующие оптимизаторы

(например, SGD, Adam, …) в их дифференциально частные аналоги, используя

Конфиденциальность TensorFlow (TF). Вы также узнаете, как настроить параметры

вводится дифференциально-частной оптимизацией. Наконец, мы научимся

измерять гарантии конфиденциальности, предоставляемые с помощью инструментов анализа, включенных в TF

Конфиденциальность.

Прежде чем мы начнем работу с DP-SGD и TF Privacy, нам нужно собрать

скрипт, который обучает простую нейронную сеть с помощью TensorFlow.

В целях сохранения фокуса этого руководства на аспектах конфиденциальности

обучение, мы включили

такой сценарий в качестве сопутствующего кода для этой записи блога в подкаталоге пошагового руководства

руководств найдено в репозитории TensorFlow Privacy. Код найден в файле

Код найден в файле mnist_scratch.py

тренирует небольшой

сверточная нейронная сеть на наборе данных MNIST для распознавания рукописного ввода.

Этот сценарий будет использоваться в качестве основы для нашего упражнения ниже.

Далее мы выделяем некоторые важные фрагменты кода из mnist_scratch.py

сценарий.

Первый фрагмент включает определение сверточной нейронной сети

используя tf.keras.layers . Модель содержит два сверточных слоя, связанных

с максимальным количеством слоев пула, полносвязным слоем и softmax. Модель

output — это вектор, каждый компонент которого указывает, насколько вероятно, что ввод будет

в одном из 10 рассмотренных нами классов задачи распознавания рукописного текста.

Если что-то из этого звучит незнакомо, рекомендуем прочитать

этот урок первым

чтобы начать работу с TensorFlow и машинным обучением.

input_layer = tf.reshape(features['x'], [-1, 28, 28, 1])

y = tf.keras.layers.Conv2D(16, 8,

шагов=2,

отступ = 'такой же',

активация = 'релу'). применить (входной_слой)

y = tf.keras.layers.MaxPool2D(2, 1).apply(y)

y = tf.keras.layers.Conv2D(32, 4,

шагов=2,

заполнение = «действительно»,

активация = 'релу'). применить (у)

y = tf.keras.layers.MaxPool2D(2, 1).apply(y)

y = tf.keras.layers.Flatten().apply(y)

y = tf.keras.layers.Dense(32, активация='relu').apply(y)

logits = tf.keras.layers.Dense(10).apply(y)

предсказанные_метки = tf.argmax (вход = логиты, ось = 1)

применить (входной_слой)

y = tf.keras.layers.MaxPool2D(2, 1).apply(y)

y = tf.keras.layers.Conv2D(32, 4,

шагов=2,

заполнение = «действительно»,

активация = 'релу'). применить (у)

y = tf.keras.layers.MaxPool2D(2, 1).apply(y)

y = tf.keras.layers.Flatten().apply(y)

y = tf.keras.layers.Dense(32, активация='relu').apply(y)

logits = tf.keras.layers.Dense(10).apply(y)

предсказанные_метки = tf.argmax (вход = логиты, ось = 1)

Второй фрагмент показывает, как модель обучается с использованием API tf.Estimator ,

который позаботится обо всем стандартном коде, необходимом для формирования используемых мини-пакетов.

для обучения и оценки модели. Чтобы подготовиться к изменениям, мы

будет делать для обеспечения дифференциальной конфиденциальности, мы по-прежнему раскрываем петлю

разные эпохи обучения: эпоха определяется как один проход по всем

тренировочные точки, входящие в тренировочный набор.

steps_per_epoch = 60000 // FLAGS.batch_size для эпохи в диапазоне (1, FLAGS.epochs + 1): # Обучить модель на одну эпоху. mnist_classifier.train(input_fn=train_input_fn, steps=steps_per_epoch) # Оценить модель и распечатать результаты eval_results = mnist_classifier.evaluate(input_fn=eval_input_fn) test_accuracy = eval_results['точность'] print('Точность теста после %d эпох: %.3f' % (epoch, test_accuracy))

Теперь мы готовы обучить нашу модель MNIST без конфиденциальности. Модель должна

достичь точности теста выше 99% после 15 эпох при скорости обучения 0,15 на

минипакеты по 256 тренировочных очков.

питон mnist_scratch.py

Стохастический градиентный спуск

Прежде чем мы углубимся в то, как DP-SGD и TF Privacy могут использоваться для обеспечения дифференциальной конфиденциальности

во время машинного обучения мы сначала даем краткий обзор стохастического

алгоритм градиентного спуска, который является одним из самых популярных оптимизаторов для

нейронные сети.

Стохастический градиентный спуск — это итерационная процедура. На каждой итерации

На каждой итерации

пакет данных случайным образом выбирается из обучающей выборки (именно здесь

стохастичность происходит от). Ошибка между предсказанием модели и

Затем вычисляются обучающие метки. Эта ошибка, также называемая потерей, затем

дифференцированы по параметрам модели. Эти производные (или

градиентов ) скажите нам, как мы должны обновить каждый параметр, чтобы привести модель

ближе к предсказанию правильной метки. Итеративно пересчитывая градиенты и

применение их для обновления параметров модели называется

спуск . Подводя итог, следующие шаги повторяются до тех пор, пока модель не

производительность удовлетворительная:

Образец мини-пакета обучающих точек

(x, y), гдеx— входные данные, аy

этикетка.Потери при вычислении (т. е. ошибка)

L(theta, x, y)между прогнозом модели

f_theta(x)и меткаy, гдететапредставляет параметры модели.

Вычислить градиент потерь

L(theta, x, y)относительно модели

параметрытета.Умножьте эти градиенты на скорость обучения и примените произведение к

обновить параметры моделитета.

Модификации, необходимые для того, чтобы сделать стохастический градиентный спуск дифференциально частным алгоритмом

Две модификации необходимы, чтобы стохастический градиентный спуск был

дифференциально частный алгоритм.

Во-первых, необходимо ограничить чувствительность каждого градиента. Другими словами, мы

необходимо ограничить, насколько каждая отдельная тренировочная точка, отобранная в мини-пакете, может

влияют на результирующий расчет градиента. Это можно сделать, обрезав каждый

градиент, рассчитанный в каждой точке обучения между шагами 3 и 4 выше.

Интуитивно это позволяет нам ограничивать, насколько каждая тренировочная точка может

влияют на параметры модели.

Во-вторых, нам нужно рандомизировать поведение алгоритма, чтобы сделать его статистически

невозможно узнать, была ли конкретная точка включена в

обучающий набор путем сравнения обновлений стохастического градиентного спуска применяется, когда

он работает с этой конкретной точкой в тренировочном наборе или без нее. Это

достигается путем выборки случайного шума и добавления его к отсеченным градиентам.

Таким образом, вот алгоритм стохастического градиентного спуска, адаптированный выше, чтобы быть

дифференциально частный:

Образец мини-пакета обучающих точек

(x, y), гдеx— входные данные, аy

этикетка.Потери при вычислении (т. е. ошибка)

L(theta, x, y)между прогнозом модели

f_theta(x)и меткаy, гдететапредставляет параметры модели.Вычислить градиент потерь

L(theta, x, y)относительно модели

параметрытета.

Градиенты обрезки для каждого обучающего примера, включенного в мини-пакет, для обеспечения

каждый градиент имеет известную максимальную евклидову норму.Добавить случайный шум к обрезанным градиентам.

Умножьте эти обрезанные и зашумленные градиенты на скорость обучения и примените

продукт для обновления параметров моделитета.

Внедрение DP-SGD с конфиденциальностью TF

Пришло время внести изменения в код, с которого мы начали, чтобы принять во внимание

две модификации, описанные в предыдущем абзаце: отсечение градиента и

шумит. Здесь в дело вступает TF Privacy: он предоставляет код, обертывающий

существующий оптимизатор переходов, чтобы создать вариант, выполняющий оба этих шага.

необходимо для получения дифференциальной конфиденциальности.

Как упоминалось выше, шаг 1 алгоритма, то есть формирование минипакетов

обучающие данные и метки, реализованы tf. API в нашем Estimator

Estimator

руководство. Таким образом, мы можем сразу перейти к шагу 2 алгоритма, описанного выше, и

вычислить потерю (то есть ошибку модели) между прогнозами модели и метками.

vector_loss = tf.nn.sparse_softmax_cross_entropy_with_logits(

метки = метки, логиты = логиты)

TensorFlow предоставляет реализации общих потерь, здесь мы используем

кросс-энтропия, которая хорошо подходит для нашей задачи классификации. Обратите внимание, как мы

вычислил потери как вектор, где каждый компонент вектора соответствует

индивидуальная тренировочная точка и метка. Это необходимо для поддержки каждого примера

манипулирование градиентом позже на шаге 4.

Теперь мы готовы создать оптимизатор. В TensorFlow объект оптимизатора может

быть создан путем передачи ему значения скорости обучения, которое используется на шаге 6

изложено выше.

Вот как выглядел бы код без дифференциальной конфиденциальности :

оптимизатор = tf.train.GradientDescentOptimizer(FLAGS.learning_rate) train_op = оптимизатор.минимизировать (потери = скалярные_потери)

Обратите внимание, что в нашем фрагменте кода предполагается, что флаг TensorFlow был

определяется для значения скорости обучения.

Теперь мы используем модуль Optimizers.dp_optimizer TF Privacy для реализации

оптимизатор с дифференциальной конфиденциальностью. Под капотом этот код реализует шаги

3-6 алгоритма выше:

оптимизатор = оптимизаторы.dp_optimizer.DPGradientDescentGaussianOptimizer(

l2_norm_clip=ФЛАГИ.l2_norm_clip,

Noise_multiplier = ФЛАГИ.noise_multiplier,

num_microbatches = ФЛАГИ.микропакеты,

Learning_rate = FLAGS.learning_rate,

население_размер = 60000)

train_op = оптимизатор.минимизировать (потери = векторные_потери)

В этих двух фрагментах кода мы использовали стохастический градиентный спуск.

оптимизатор, но его можно заменить другим оптимизатором, реализованным в

ТензорФлоу. Например, AdamOptimizer можно заменить на DPAdamGaussianOptimizer . В дополнение к стандартным оптимизаторам уже

В дополнение к стандартным оптимизаторам уже

включены в TF Privacy, большинство оптимизаторов являются объектами дочернего класса

тф.поезд.Оптимизатор

можно сделать дифференциально закрытым, вызвав optimizers.dp_optimizer.make_gaussian_optimizer_class() .

Как видите, нужно изменить только одну строку, но есть несколько вещей, которые нужно изменить.

об этом лучше всего развернуть, прежде чем мы продолжим. Помимо скорости обучения, мы

передал размер обучающей выборки в качестве параметра населения_размера . Это

используется для измерения степени достигнутой конфиденциальности; мы вернемся к этому

бухгалтерский аспект позже.

Что еще более важно, TF Privacy представляет три новых гиперпараметра для

объект оптимизатора: l2_norm_clip , шум_множитель и число_микропакетов .

Возможно, вы поняли, что такое l2_norm_clip и шум_множитель , из двух

изменения, описанные выше.

Параметр l2_norm_clip — максимальная евклидова норма каждого отдельного

градиент, вычисляемый на отдельном обучающем примере из мини-пакета. Этот

параметр используется для ограничения чувствительности оптимизатора к индивидуальному обучению

точки. Обратите внимание, что для того, чтобы оптимизатор мог вычислить эти

пример градиентов, мы должны передать ему вектор потеря, как определено ранее, скорее

чем средние потери по всей мини-партии.

Затем параметр Noise_Multiplier используется для управления уровнем шума.

выбираются и добавляются к градиентам до того, как они будут применены оптимизатором.

Как правило, чем больше шума, тем лучше уединение (часто, но не обязательно, в

за счет меньшей полезности).

Третий параметр относится к аспекту DP-SGD, который не обсуждался

ранее. На практике отсечение градиентов для каждого примера может быть

вредно для производительности нашего подхода, потому что вычисления не могут

больше не будет пакетироваться и распараллеливаться с гранулярностью мини-пакетов. Следовательно, мы

Следовательно, мы

ввести новую степень детализации, разделив каждую мини-партию на несколько

микропартии [McMahan et al.]. Скорее, чем

отсечение градиентов на основе отдельных примеров, мы обрезаем их на основе микропакетов.

Например, если у нас есть мини-пакет из 256 обучающих примеров, а не

обрезав каждый из 256 градиентов по отдельности, мы бы обрезали 32 градиента.

усредняется по микропакетам из 8 обучающих примеров, когда число_микропартий=32 .

Это обеспечивает некоторую степень параллелизма. Следовательно, можно думать о

num_microbatches в качестве параметра, который позволяет нам снижать производительность (когда

параметр установлен на маленькое значение) с утилитой (когда параметр установлен

до значения, близкого к размеру мини-пакета).

После внесения всех этих изменений попробуйте снова обучить модель с помощью

оптимизатор дифференциально-частного стохастического градиента. Вы можете использовать

следуя значениям гиперпараметров, чтобы получить разумную модель (95% тест

точность):

Learning_rate=0,25 шум_множитель = 1,3 l2_norm_clip=1.5 размер партии = 256 эпох=15 число_микробатчей = 256

Измерение достигнутой гарантии конфиденциальности

На этом этапе мы внесли все изменения, необходимые для обучения нашей модели с помощью

дифференциальная конфиденциальность. Поздравляем! Тем не менее, мы по-прежнему упускаем один важный

часть головоломки: мы не рассчитали достигнутую гарантию конфиденциальности. Отзывать

две модификации, которые мы внесли в исходный стохастический градиентный спуск

алгоритм: обрезать и рандомизировать градиенты.

Специалистам по машинному обучению понятно, как отсечение градиентов ограничивает

способность модели переобучаться к любой из ее тренировочных точек. Фактически,

Отсечение градиента обычно используется в машинном обучении, даже когда конфиденциальность

не забота. Интуиция для введения случайности в алгоритм обучения

который уже рандомизирован, немного сложнее, но это дополнительное

рандомизация необходима, чтобы было трудно сказать, какие поведенческие аспекты

модель, определяемая изученными параметрами, возникла из случайности и которая возникла

из тренировочных данных. Без случайности мы могли бы задавать вопросы

Без случайности мы могли бы задавать вопросы

например: «Какие параметры выбирает алгоритм обучения, когда мы обучаем его на

этот конкретный набор данных?» Со случайностью в алгоритме обучения мы вместо этого

задавать такие вопросы, как: «Какова вероятность того, что алгоритм обучения будет

выбирать параметры в этом наборе возможных параметров, когда мы обучаем его на этом

конкретный набор данных?»

Мы используем версию дифференциальной конфиденциальности, которая требует, чтобы вероятность

изучение любого конкретного набора параметров остается примерно таким же, если мы изменим

один обучающий пример в обучающей выборке. Это может означать добавление обучения

например, удалить обучающий пример или изменить значения в рамках одного обучающего

пример. Интуиция такова, что если одна тренировочная точка не влияет на

результат обучения, информация, содержащаяся в этой точке обучения, не может быть

запоминается, и конфиденциальность лица, предоставившего эти данные, указывает на нашу

набор данных уважается. Мы часто называем эту вероятность бюджетом конфиденциальности:

Мы часто называем эту вероятность бюджетом конфиденциальности:

меньшие бюджеты конфиденциальности соответствуют более сильным гарантиям конфиденциальности.

Учет, необходимый для расчета бюджета конфиденциальности, потраченного на обучение нашей машины

модель обучения — еще одна функция, предоставляемая TF Privacy. Зная, какой уровень

была достигнута дифференциальная конфиденциальность, что позволяет нам оценить падение

полезность, часто наблюдаемая при переходе на дифференциально-приватный

оптимизация. Это также позволяет нам объективно сравнивать две модели, чтобы определить

какой из двух больше сохраняет конфиденциальность, чем другой.

Прежде чем мы получим ограничение на гарантию конфиденциальности, достигнутую нашим оптимизатором, мы

сначала необходимо определить все параметры, которые имеют отношение к измерению

потенциальная потеря конфиденциальности, вызванная обучением. Это шум_множитель ,

коэффициент выборки q (вероятность того, что отдельная обучающая точка

включены в мини-пакет), а количество шагов оптимизатор берет на себя.

данные тренировки. Мы просто сообщаем значение Noise_Multiplier , предоставленное

оптимизатор и вычислить коэффициент дискретизации и количество шагов следующим образом:

шум_множитель = ФЛАГС.шум_множитель Вероятность_выборки = ФЛАГС.размер_пакета / 60000 шаги = FLAGS.epochs * 60000 // FLAGS.batch_size

На высоком уровне анализ конфиденциальности измеряет, насколько включено или исключено любое

конкретная точка в обучающих данных, вероятно, изменит вероятность того, что

мы изучаем любой конкретный набор параметров. Другими словами, анализ измеряет

разница между распределениями параметров модели на соседних обучающих

наборы (пары любых тренировочных наборов с расстоянием Хэмминга, равным 1). В Конфиденциальности TF,

мы используем дивергенцию Реньи, чтобы измерить это расстояние между распределениями.

Действительно, наш анализ выполняется в рамках Дифференциальной конфиденциальности Реньи.

(RDP), который представляет собой обобщение чистой дифференциальной конфиденциальности.

[Миронов]. RDP является полезным инструментом здесь, потому что

он особенно хорошо подходит для анализа различных гарантий конфиденциальности

обеспечивается сэмплированием с последующим добавлением гауссовского шума, как градиенты

рандомизированы в реализации TF Privacy оптимизатора DP-SGD. 9-5 , потому что MNIST имеет

60000 тренировочных очков.

Epsilon измеряет надежность нашей гарантии конфиденциальности. В случае

дифференциально частное машинное обучение, оно дает ограничение на то, насколько

вероятность выхода конкретной модели может варьироваться путем включения (или удаления)

один тренировочный пример. Обычно мы хотим, чтобы это была небольшая константа.

Однако это только верхняя граница, и большое значение эпсилон может

по-прежнему означают хорошую практическую конфиденциальность.

Библиотека конфиденциальности TF предоставляет два метода для получения конфиденциальности.

гарантии, полученные с помощью трех параметров, указанных в последнем фрагменте кода: calculate_rdp

и get_privacy_spent .

Эти методы находятся в его модуле analysis.rdp_accountant . Вот как их использовать.

Сначала нам нужно определить список порядков, при которых дивергенция Реньи будет

вычислено. Первый метод calculate_rdp возвращает дифференциальную конфиденциальность Реньи.

достигается с помощью механизма Гаусса, примененного к градиентам в DP-SGD, для каждого из

эти заказы.

заказов = [1 + x / 10. для x в диапазоне (1, 100)] + список (диапазон (12, 64))

rdp = вычисление_rdp(q=выборка_вероятность,

Noise_multiplier = ФЛАГИ.noise_multiplier,

шаги = шаги,

заказы = заказы)

Затем метод get_privacy_spent вычисляет лучший эпсилон для данного

target_delta значение дельты путем взятия минимума по всем ордерам.

эпсилон = get_privacy_spent (заказы, rdp, target_delta = 1e-5) [0]

Запуск приведенных выше фрагментов кода со значениями гиперпараметров, использованными во время

обучение оценит значение эпсилон , которое было достигнуто

дифференциально частный оптимизатор и, следовательно, сила гарантии конфиденциальности

который поставляется с моделью, которую мы обучали.

применить (входной_слой)

y = tf.keras.layers.MaxPool2D(2, 1).apply(y)

y = tf.keras.layers.Conv2D(32, 4,

шагов=2,

заполнение = «действительно»,

активация = 'релу'). применить (у)

y = tf.keras.layers.MaxPool2D(2, 1).apply(y)

y = tf.keras.layers.Flatten().apply(y)

y = tf.keras.layers.Dense(32, активация='relu').apply(y)

logits = tf.keras.layers.Dense(10).apply(y)

предсказанные_метки = tf.argmax (вход = логиты, ось = 1)

применить (входной_слой)

y = tf.keras.layers.MaxPool2D(2, 1).apply(y)

y = tf.keras.layers.Conv2D(32, 4,

шагов=2,

заполнение = «действительно»,

активация = 'релу'). применить (у)

y = tf.keras.layers.MaxPool2D(2, 1).apply(y)

y = tf.keras.layers.Flatten().apply(y)

y = tf.keras.layers.Dense(32, активация='relu').apply(y)

logits = tf.keras.layers.Dense(10).apply(y)

предсказанные_метки = tf.argmax (вход = логиты, ось = 1)

batch_size

для эпохи в диапазоне (1, FLAGS.epochs + 1):

# Обучить модель на одну эпоху.

mnist_classifier.train(input_fn=train_input_fn, steps=steps_per_epoch)

# Оценить модель и распечатать результаты

eval_results = mnist_classifier.evaluate(input_fn=eval_input_fn)

test_accuracy = eval_results['точность']

print('Точность теста после %d эпох: %.3f' % (epoch, test_accuracy))

batch_size

для эпохи в диапазоне (1, FLAGS.epochs + 1):

# Обучить модель на одну эпоху.

mnist_classifier.train(input_fn=train_input_fn, steps=steps_per_epoch)

# Оценить модель и распечатать результаты

eval_results = mnist_classifier.evaluate(input_fn=eval_input_fn)

test_accuracy = eval_results['точность']

print('Точность теста после %d эпох: %.3f' % (epoch, test_accuracy))

learning_rate)

train_op = оптимизатор.минимизировать (потери = скалярные_потери)

learning_rate)

train_op = оптимизатор.минимизировать (потери = скалярные_потери)

5

размер партии = 256

эпох=15

число_микробатчей = 256

5

размер партии = 256

эпох=15

число_микробатчей = 256